对人工智能和高性能计算 (HPC) 的持续需求推动了对更多数据中心容量的需求。新数据中心的建设仍在继续,但也面临挑战。土地是一个关键考虑因素,尤其是在决定数据中心位置的诸多因素方面——可靠的电力供应、充足的宽带基础设施、冷却用水、与最终用户的距离以及适用的分区和许可。所有这些因素共同推动着创新,数据中心运营商正在重新思考如何配置巨大的内部空间。房地产谚语“位置,位置,还是位置”,既指建筑物的内部空间,也指其所在位置。

超越计算能力:电力和冷却是决定因素

无论是新建数据中心还是改造现有数据中心,目标都是在更小的空间内实现更高的计算能力(即更高的密度)。但考虑到现代数据中心所需的大量能源,这是否可行?

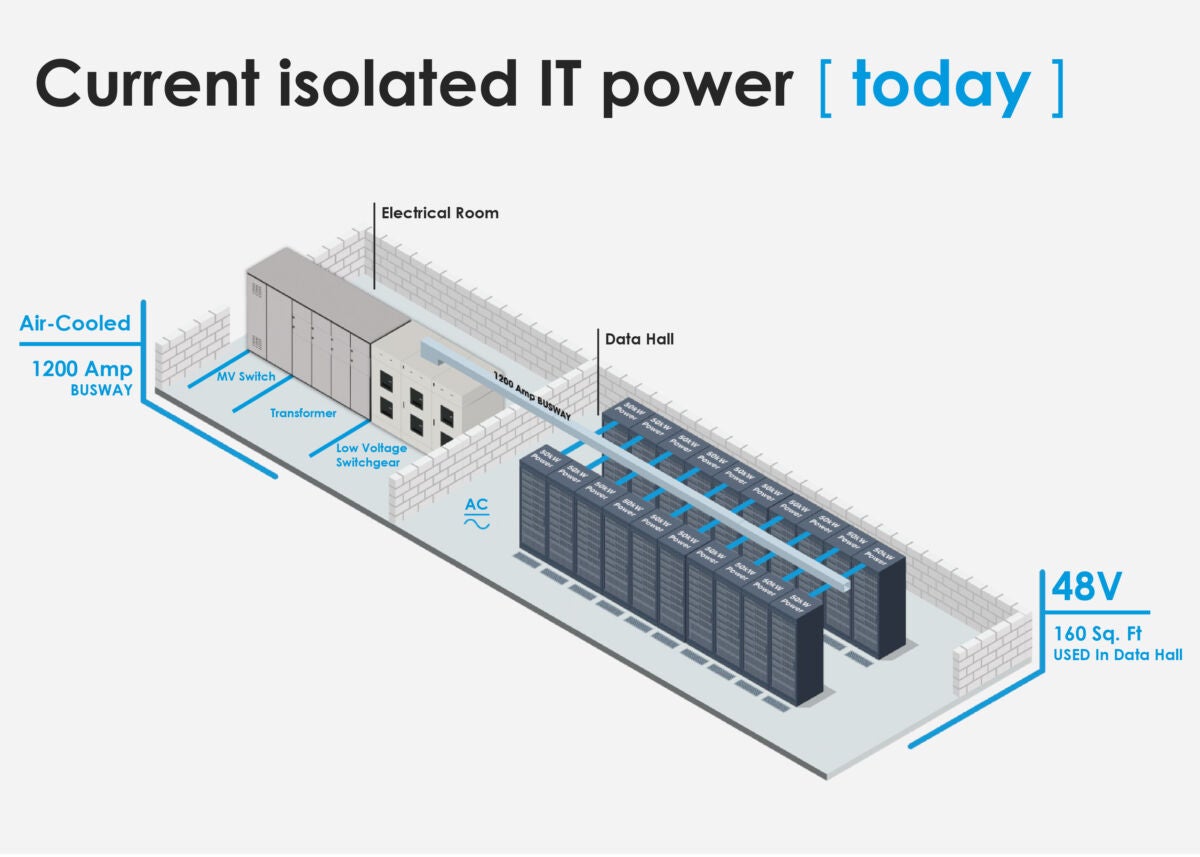

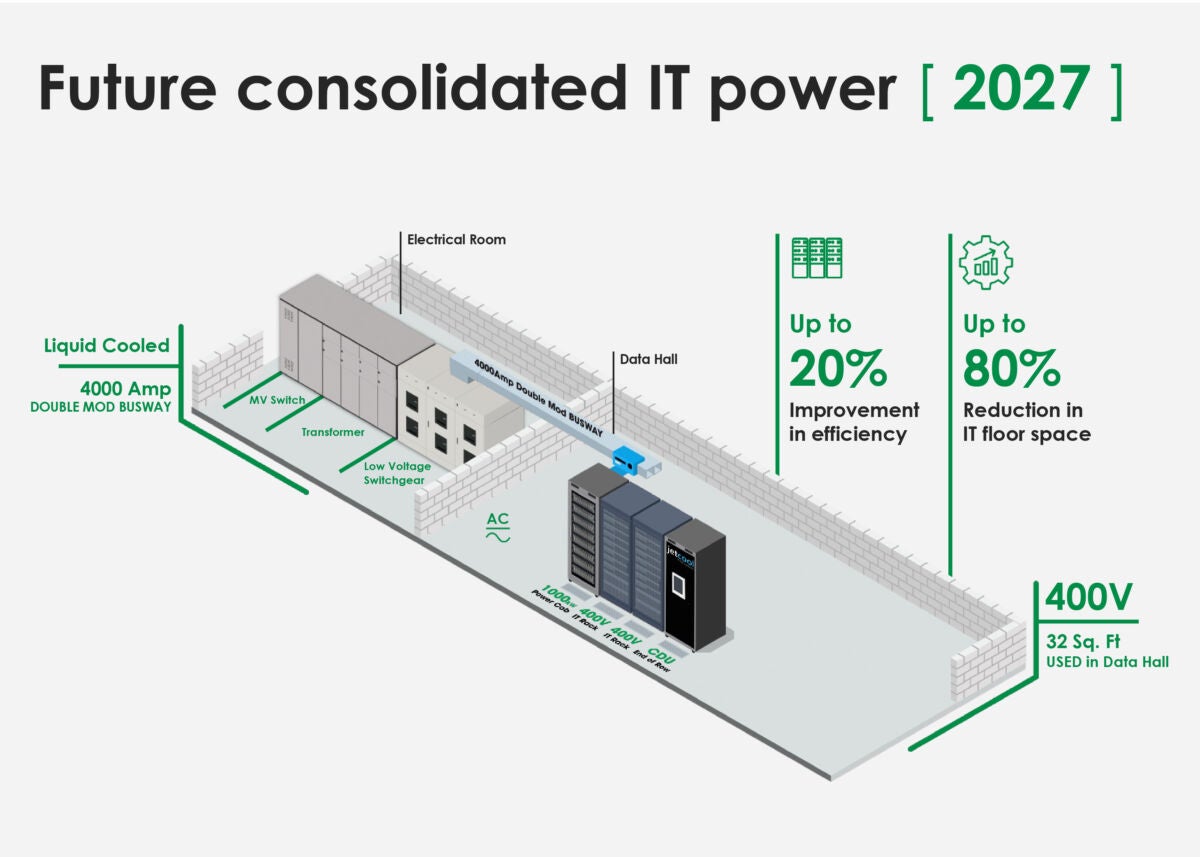

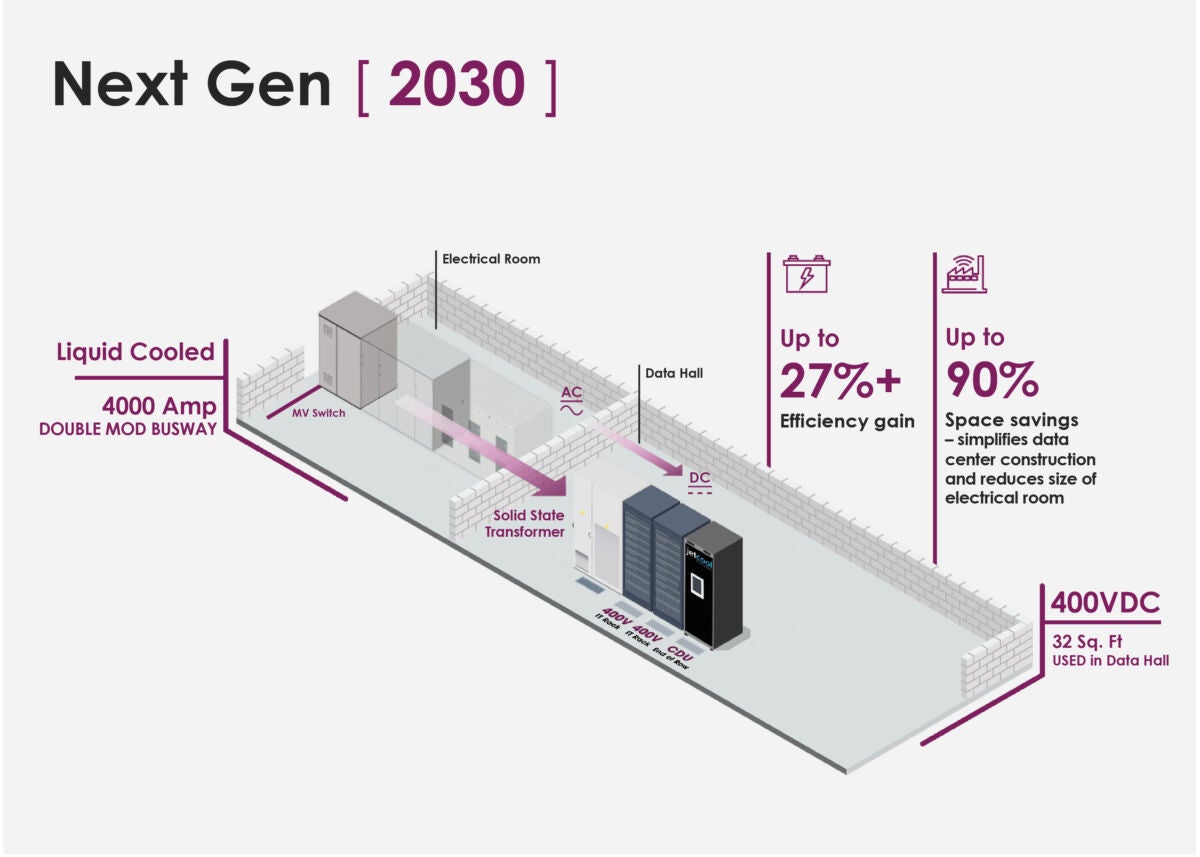

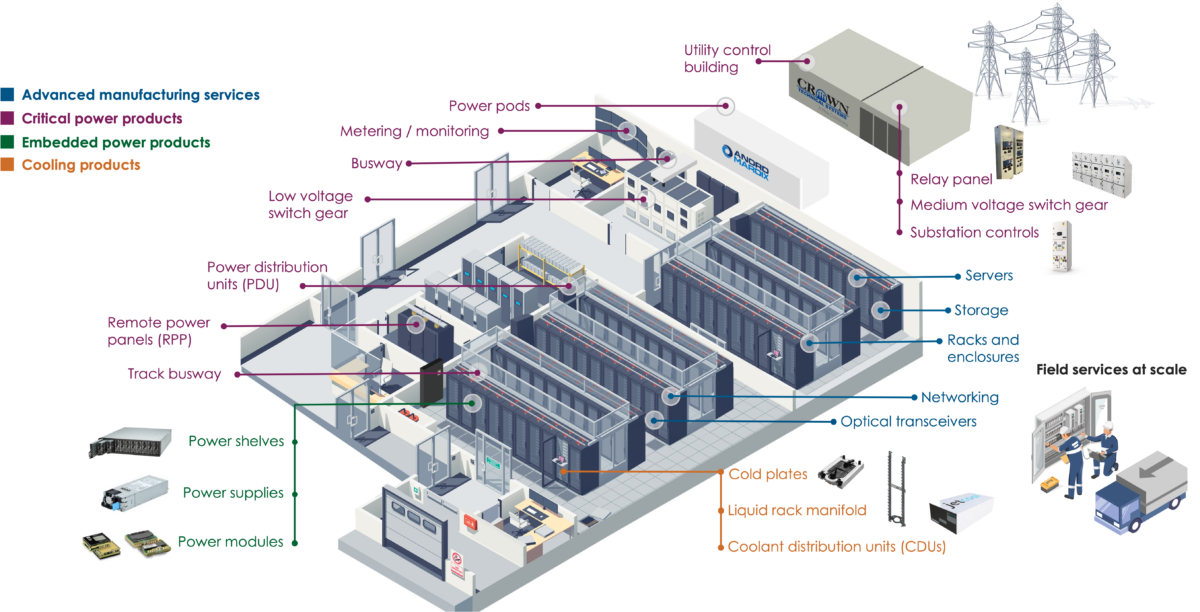

传统上,数据中心的灰色空间与白色空间的比例大约为 1:1,根据 RICS 建筑杂志这意味着,每平方英尺用于电气和冷却设备(开关设备、不间断电源 (UPS) 变压器、机房空调 (CRAC) 机组、冷水机组等占用的灰色空间),就会有一平方英尺的空白空间用于服务器、存储和网络设备等 IT 设备。超大规模数据中心的目标比例通常接近 1:3,将更多的建筑面积分配给 计算. 精确的比例受到许多操作因素的影响,包括:

- 功率密度 功耗始于芯片。中央处理器 (CPU) 处理各种计算任务,运行功率在 150 瓦至 300 瓦之间。诸如图形处理器 (GPU) 之类的加速器,专为人工智能中广泛使用的大规模并行计算而设计,其功耗是 CPU 的 10 倍,运行功率高达 1,500 瓦,且仍在不断增加。每平方英尺功耗更高的数据中心通常需要更大的占地面积来安装电气和冷却基础设施。

- 冷却技术 随着计算密度的提升,数据中心的温度也随之升高。就在几年前,典型的服务器机架设计功耗仅为10kW。而现在,大多数服务器机架功耗已达40kW至60kW,超大规模数据中心的功耗也随之上升。 为 1+ MW 做准备。 在这种性能水平下,产生的热量将比以前多20倍。冷却基础设施可能会使灰空间与白空间的比率超过1:1,因为空气冷却需要增加管道数量和更多的CRAC系统(最高可达约50 kW),而液体冷却则需要更多的管道、泵和密封系统。