人工智能、机器学习 (ML)、加密货币和 云计算 正在彻底改变数据中心的面貌。数据中心需要支持从高分辨率视频流到复杂的人工智能驱动数据处理等一系列需要大量计算能力的服务,因此正迅速成为全球能源资源的最大消耗者之一。国际能源署预测,如果目前的趋势继续下去,到 2026 年,这些数据中心的能源消耗量可能会超过 1,000 太瓦时,与 2022 年记录的 460 太瓦时相比大幅增加。

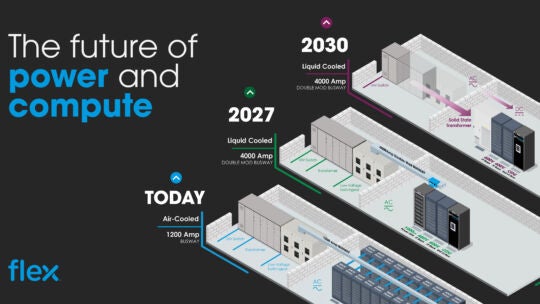

随着数据中心不断发展和适应处理需求,它们面临着重大挑战。在数据吞吐量空前的时代,配电策略正在不断发展,以确保能源效率、减少热量产生、优化空间利用率和有效的成本管理。

传统上, 数据中心的所有设备供电, 设计用于处理每个机柜 30-40kW 的电源。然而,高功率 CPU 和 GPU 的出现,例如 Nvidia 的 H100 AI 加速器,它包含 800 亿个晶体管,热设计功率 (TDP) 为 700W,要求重新评估这一标准。这些组件以其巨大的热设计功率 (TDP) 为特征,突破了传统冷却和电源系统可以管理的界限。随着处理能力的不断扩大,单个机柜的功率要求将超过 200kW。