Una definición de "inteligencia artificial" es un software que imita y genera comportamientos similares a los humanos. Si esto es deseable o no es un tema de debate y habrá muchos que preferirían respuestas racionales y deterministas garantizadas de las máquinas y los servicios automatizados que nos rodean. Sin embargo, la IA llegó para quedarse y, con el apoyo de la nube, representa un negocio que vale alrededor de $136B en 2022, y se proyecta que aumentará a casi $2T para 2030. Según Grand View ResearchUna función valiosa de la IA es la minimización del consumo de energía tanto en el hogar como en la industria, pero la computación de IA en sí misma consume enormes cantidades de energía, tanto en la fase de "aprendizaje" como en el uso rutinario. Los centros de datos más grandes requieren una alimentación de más de 100 MW como resultado y esto representa un alto costo en dólares y para el medio ambiente, a través de la huella de carbono resultante. Estamos considerando la IA, pero por supuesto otras cargas mayores incluyen la minería de criptomonedas, el IoT y las redes sociales/streaming.

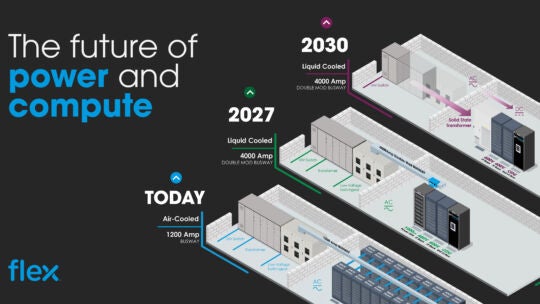

Un caso de éxito ha sido el crecimiento relativamente lento del consumo de energía de los centros de datos en comparación con el aumento de la velocidad de procesamiento de datos, y esto se ha debido en gran medida a las mejoras continuas en la eficiencia energética del hardware y sus fuentes de alimentación. Sin embargo, se dice que los requisitos de densidad de potencia del rack son tres veces más altos para la IA que para las funciones tradicionales de los centros de datos y cada vez es más difícil lograr mayores ganancias de eficiencia. Como resultado, los diseñadores de sistemas revisan continuamente su arquitectura de suministro de energía para buscar formas de mejorar la eficiencia en el proceso de conversión de CA de la red eléctrica a los niveles de CC inferiores a 1 V que suelen requerir las GPU, las CPU, los FPGA y los ASIC.