在人工智能数据中心时代,电力和计算基础设施的设计、管理和部署变得密不可分。电力、计算和冷却组件越来越多地被作为一个集成系统进行规划和优化。然而,由于人工智能工作负载需要高密度的计算机架,电力组件必须进行拆分,以便为更密集的服务器腾出空间——而且它们必须比以往更高效地提供更多电力。仅从额定功耗来看,兆瓦级GPU机架产生的热量大约是满载CPU机架的50倍。

“边车”出现了

由开放计算项目 (OCP) 开发的 Open Rack v3 (ORv3) 标准旨在支持更高的功率密度并实现诸如液冷等高级功能。 灵活、可扩展的机架 这种机架能够适应不断发展的人工智能和高性能计算工作负载,并且兼容各种IT设备。在这种情况下,每个集成机架都是一个“单元”。但1兆瓦机架的出现,标志着颠覆传统模式的革新。

ORv3机架最初的设计容量为每机架18千瓦至36千瓦,至今仍是许多工作负载的黄金标准,但它们并非为即将到来的兆瓦级机架而设计。规划1兆瓦的IT机架已超出标准ORv3规范的极限,需要进行重大设计修改,并使用侧挂机架来管理电源和冷却需求。

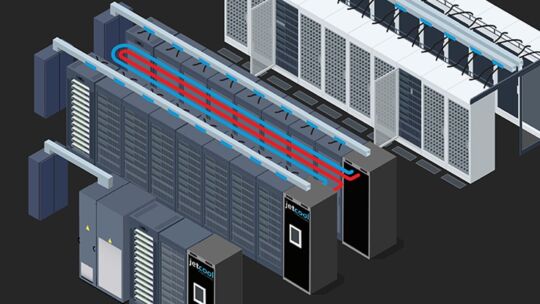

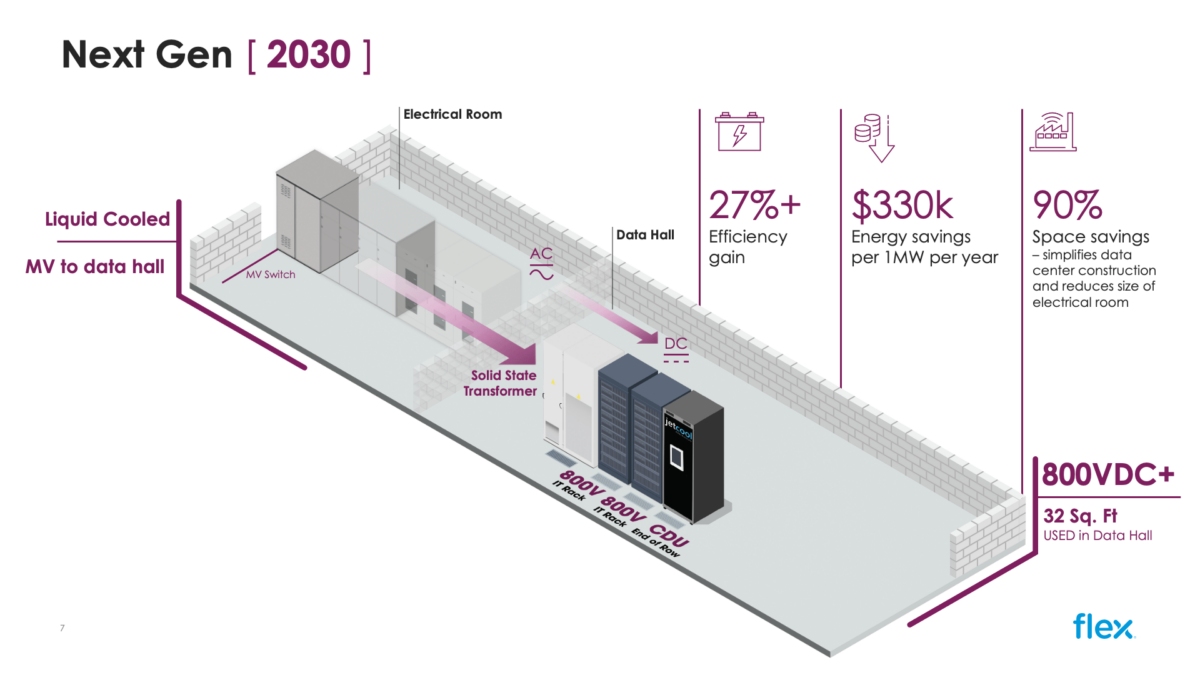

正因如此,一些超大规模数据中心运营商正在OCP的支持下合作开发Mt. Diablo标准,例如新的电源机架规范,该规范支持高压直流电源基础设施和每个机架1兆瓦的IT负载,并将电源、冷却和IT分离,从而提高每项功能的利用率。与以往各个机架各自独立运行不同,冷却液分配单元(CDU)、电源分配单元(PDU)和IT机架(或多个机架)组成一个整体单元,共同支持工作负载。CDU和PDU相当于IT机架的“边车”。 Flex人工智能基础设施平台 就是一个绝佳的例子,它将电源、冷却和计算统一到预先设计的模块化参考设计中,用于下一代数据中心。