满足未来高性能计算的冷却需求

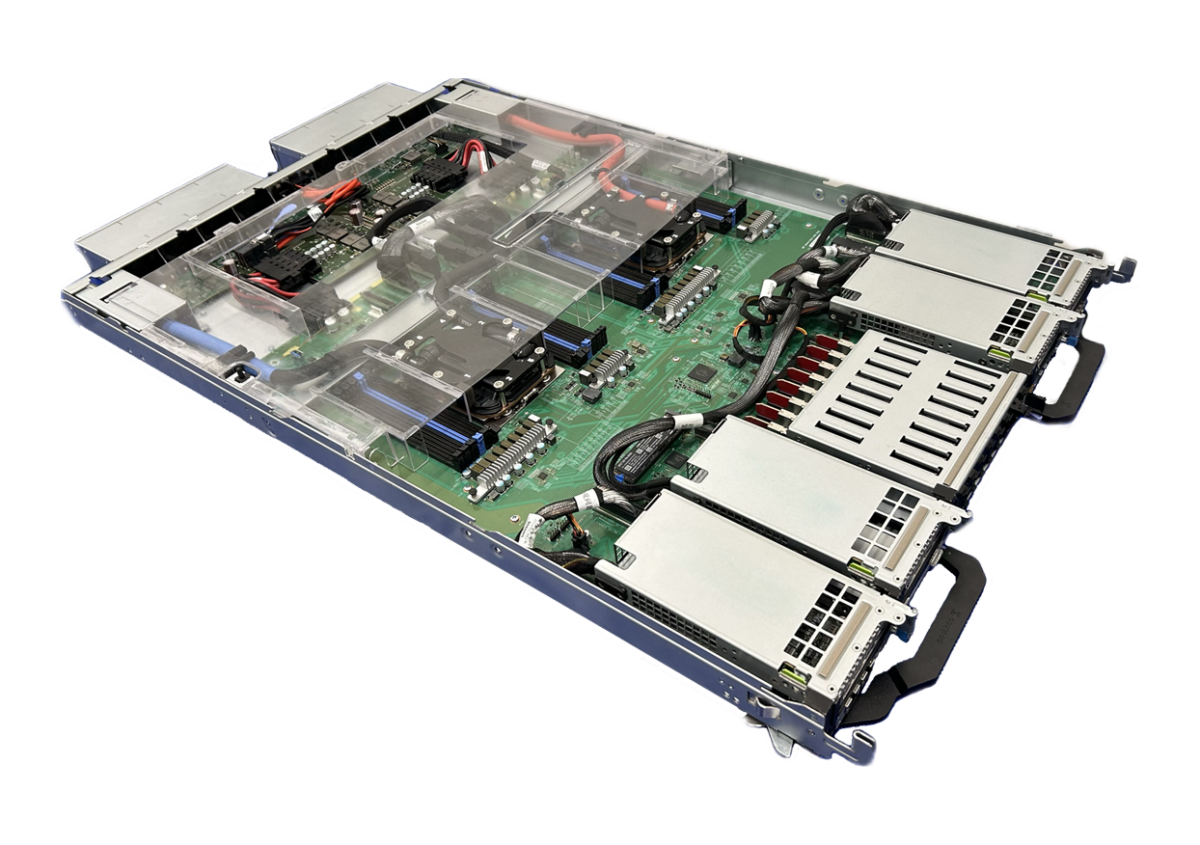

Flex 是从电网到芯片的先进制造、数据中心 IT 和电力基础设施解决方案的全球首选合作伙伴,提供可定制的服务器设计,以满足超大规模企业和企业客户的特定电力、计算和冷却需求。Flex 的端到端基础设施解决方案将计算、配电和 JetCool 的液体冷却技术集成到一个完整的机架级解决方案中,提供集成的冷却和服务器技术,以无与伦比的效率和可扩展性支持最苛刻的 AI 和高性能计算 (HPC) 工作负载。

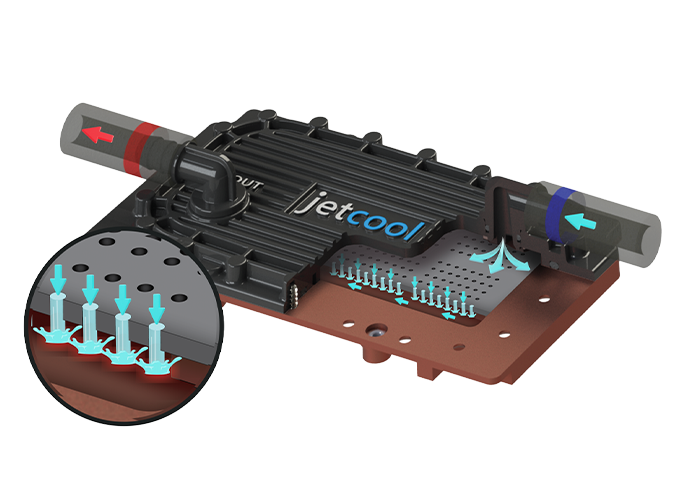

通过将 Flex 的大批量制造专业知识与 JetCool 的专利微对流冷却® 技术,超大规模企业可以部署先进的 AI 和 HPC 系统,同时缩短上市时间。与传统微通道冷却相比,JetCool 的微喷射技术利用冲击微喷射实现显著降低的热阻。

这项创新推动了芯片级的卓越散热性能,加速了热管理优化并实现了更高的性能密度。Flex 系统设计中微喷射冷却的集成降低了温度梯度,并支持在复杂的硅架构中实现更均匀的热分布。

JetCool 的直接芯片液体冷却 (D2C) 技术是冷却技术中的差异化因素,因为它能够针对芯片架构内的热通量集中。

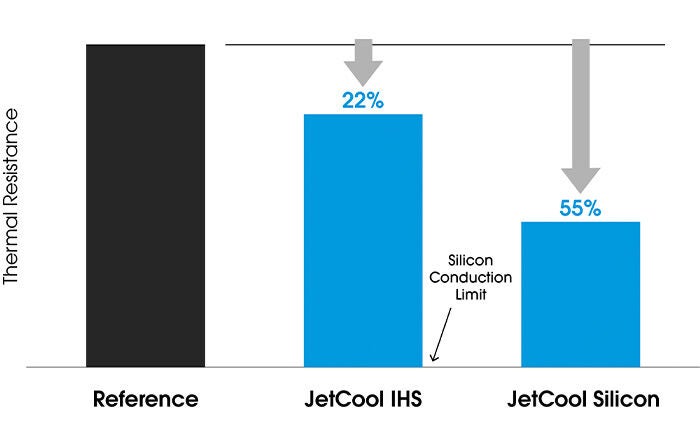

图 1. 减少扩散带来的热性能优势

随着芯片架构变得越来越复杂,热通量分布也趋于不均匀。此外,芯片封装也已发展成为更倾向于直接贴在芯片上的冷却解决方案,而不再使用集成式散热器。

即使采用一体式散热器,热通量的明显不均匀性仍会持续存在(例如 AMD EPYC),而使用 JetCool 的微对流冷却技术 (图 1) 可以通过热点定位来降低最高温度,从而提高性能。

调整冷却解决方案中的热传递分布的能力可使芯片温度更加均匀,减少芯片中的热应力并最大程度延长芯片寿命。重要的是,调整芯片内的冷却配置的能力不受任何原生尺寸限制,冷却较大的芯片不会产生较大的温度不均匀性或较大的压降,而竞争技术可能会出现这种情况。

使用 JetCool 的微对流冷却方法优化冷却配置并将冷却装置更靠近芯片,不仅可以提供更均匀的芯片温度,还可以提高芯片本身的效率。

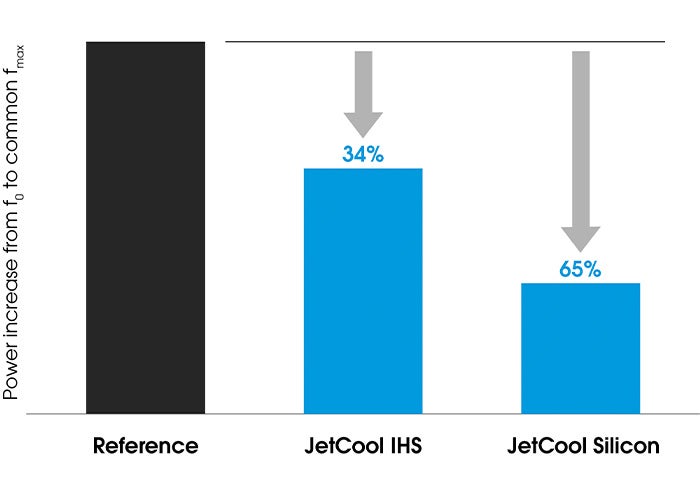

通过将其靠近芯片并将热传递集中在硅片热通量最高的区域来改善冷却效果,可以减少将处理器工作频率提升 65% 所需的功率增加(图 2)。

JetCool 的产品组合解决了当今芯片冷却面临的所有挑战,包括总功率(目前冷却芯片组超过 1500W)和成功控制远高于 5 W/mm2 的热通量。这些解决方案包括全封闭式冷却板、SmartPlates(带或不带面积增强)到我们的直接到芯片解决方案,再到 SmartLids(直接密封到芯片封装以获得更高的冷却性能)。

图 2. 降低功率要求以提高处理器工作频率

JetCool 的冷却技术组合为超大规模企业做好了未来准备,无需采用两相冷却即可应对急剧上升的热负荷和热通量。JetCool 将使下一代芯片组无需担心瞬态操作或临界热通量等悬崖效应,而这些是两相冷却特有的重要问题。

Flex 和 JetCool 的合作带来 大功率液冷机架 每机架最高支持 120 kW,并拥有清晰的升级路径,可升级至每机架 300 kW,以适应下一代计算密集型 AI 和 HPC 工作负载。这种模块化可扩展性确保数据中心能够满足当今最先进 AI 系统(例如 NVIDIA NVL72)的散热和功耗需求,同时为即将发布的硬件版本做好准备。

JetCool 推出全新 6U 机架内冷却液分配装置 (CDU)在 2024 年 OCP 全球峰会上亮相,旨在为每个机架提供超过 300 kW 的冷却能力。这种高效 CDU 架构可无缝集成到高密度机架中,使超大规模数据中心能够满足不断变化的热管理需求,而不会影响能源效率或可维护性。

Flex 的整套配电和管理解决方案与 JetCool 的热技术相得益彰,打造出完整的机架级系统,可最大限度提高电力利用率并最大限度减少能源损失。

Flex 的电源管理基础设施与 JetCool 的冷却技术无缝集成,为高密度计算环境提供精确的功率分配和卓越的效率。

JetCool 液体冷却系统的一个主要优点是无需使用大功率风扇,从而显著降低传统风冷设计带来的寄生功耗。这可大幅节省能源,并带来更安静、更高效的数据中心环境。JetCool 的创新由 ARPA-E 资助,确保即使功率密度增加,冷却也不再成为瓶颈。